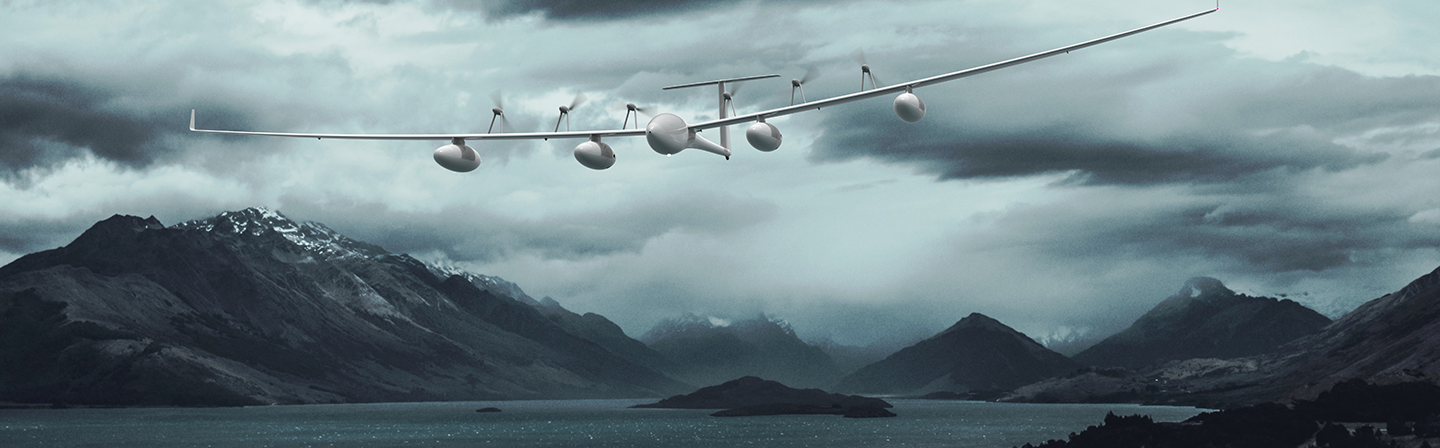

Im Rahmen des Projektes „BLUEASSIST“ wurde im Verbund mit den Industriepartnern Lange Research Aircraft und M4COM ein Konzept für ein autonom fliegendes, hybrid-elektrisch angetriebenes und mit verschiedenster Sensorik als Nutzlast ausgestattetes Segelflugzeug entwickelt.

Auf Grund leistungsfähiger Brennstoffzellen und einer damit verbundenen Flugdauer von bis zu 40 Stunden würde sich ein solches Fernerkundungssystem u.a. zum Monitoring großflächig maritimer Einsatzgebiete eignen. Dazu zählen Überwachung der Schifffahrt, Detektion von Ölverschmutzungen, aber auch weitere meist hoheitliche Aufgaben wie bspw. Überwachung von Großschadenslagen wie Waldbrand und Hochwasser oder Grenzschutz. Durch die extrem lange Flugdauer in entlegenen Regionen werden besondere Anforderungen an die Datenerfassung, -verarbeitung, -auswertung und die Kommunikation mit dem UAV gestellt. Um das Fernerkundungssystem optimal zu nutzen und den Datentransfer nicht zu überlasten, wurde u.a. eine automatisierte Onboard-Verarbeitung und -Analyse der Daten konzipiert. Eine vollständige und detaillierte Auswertung der Daten wäre dann in der angegliederten Bodenstation durch leistungsfähigere und rechenintensivere Algorithmen möglich.

Die wesentlichen Tätigkeiten und Ziele des Verbundprojektes waren:

- Vertiefter Austausch mit potentiellen Anwendern

- Konzeption eines Gesamtsystems, bestehend aus UAV, darauf abgestimmter Nutzlast zur Datenerfassung und Übertragung und angegliederter Bodenstation

- Entwicklung einer mit Brennstoffzellen gespeisten, hybrid-elektrischen Antares E2

- Konzept für die Integration eines Multisensorsystems, einer Datenübertragungseinheit und einer Bodenkontrollstation

Beteiligung des Fraunhofer IOSB – Abteilung SZA

Multisensorielle Datenverarbeitung und –Auswertung (onboard + Bodenstation)

Weitverbreitete Kamerasysteme zur Überwachung aus der Luft bieten Firmen wie Trakka Systems mit dem Modell TC-300 an. Durch den schwenkbaren und stabilisierten Aufbau mit integrierter Thermal- und HDTV-Kamera, ist mit durchgehendem Zoom eine ausreichend hohe Flexibilität gewährleistet. Um die Leistungsfähigkeit dieses Kamerasystems im Bereich der Schiffserkennung aus der Luft zu prüfen, wurde am Fraunhofer IOSB Künstliche Intelligenz (mit MS COCO vortrainierte Mask R-CNN Netzwerke) auf einen Videoausschnitt der Kamera angewendet. Mask R-CNN sind Instanz-Segmentierungsverfahren, bei denen eingehende Bilder durch verschiedene Netzwerke (FPN, RPN) verarbeitet, sowie Merkmale segmentiert und klassifiziert werden. Auf Grund der Modularität und der mehrphasigen Struktur lassen sich Mask R-CNN vergleichsweise leicht auf neue Szenarien trainieren.

Dabei beteiligte sich das Fraunhofer IOSB mit seiner Abteilung SZA an der:

- Untersuchung von Methoden für automatisierte Daten(vor)auswertung, Filterung und Kompression onboard im Hinblick auf eine effiziente Datenübertragung

- Entwicklung anwendungsspezifischer Auswerteverfahren und Konzeption der dafür notwendigen Hardware-Komponenten für die Bodenstation

Fraunhofer-Institut für Optronik, Systemtechnik und Bildauswertung IOSB

Fraunhofer-Institut für Optronik, Systemtechnik und Bildauswertung IOSB