Gruppenbeschreibung

Die automatische Analyse von Videodaten bzgl. anwendungsspezifischer Inhalte hat in den letzten Jahren stetig an Bedeutung gewonnen. In Umgebungen mit definierter Komplexität, welche vorwiegend industriellen Umfeld zu finden sind, zählen videobasierte Automatisierungsansätze heutzutage zu den etablieren Technologien. Trotz aller Fortschritte in den vergangenen Jahren stellt die automatische Analyse von Videodaten unter unkontrollierten Bedingungen dennoch ein in weiten Bereichen ungelöstes Problem dar. Eine der großen Herausforderungen resultiert dabei aus der Komplexität und Variabilität beobachteter Szenen. Hierzu zählen zum Beispiel starke Formveränderungen von Objekten, ebenso wie die Anzahl der zu detektierenden Objekte und die Strukturierung des Hintergrunds.

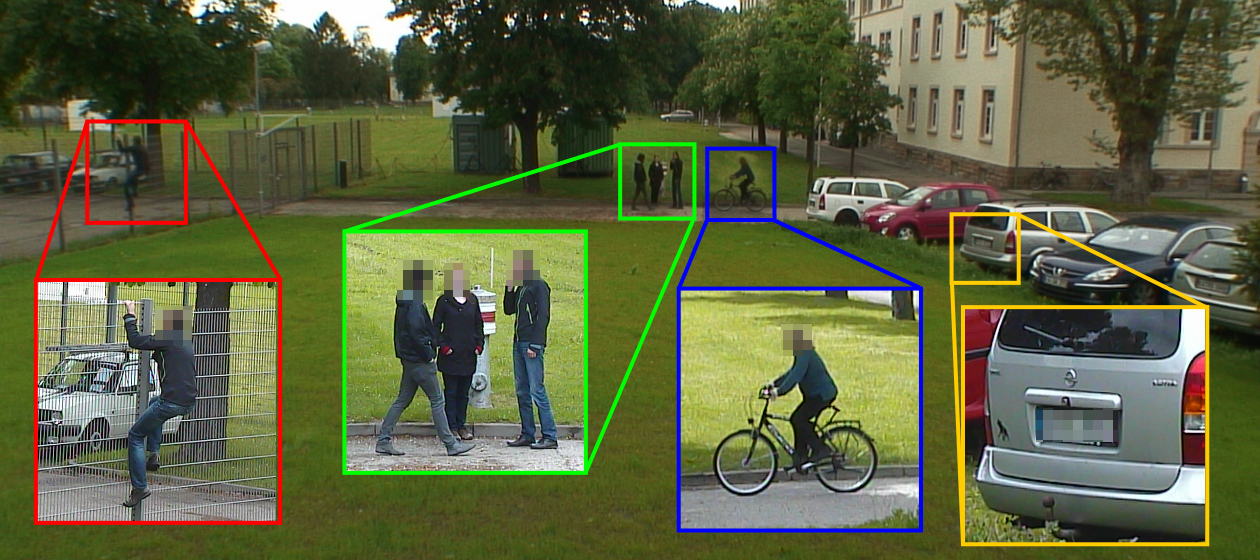

Unter Berücksichtigung dieser Aspekte bearbeiten wir schwerpunktmäßig folgende Fragestellungen:

- Robuste Videoanalyse. Schwerpunkt der Forschungsarbeiten liegt in der Analyse von Videodaten auf bewegten Plattformen in unstrukturierten Umgebungen. Hierzu zählt die Detektion- und Verfolgung von Objekten, ebenso wie die Entwicklung effizienter Vorverarbeitungsalgorithmen welche sich für Anwendungen auf frei beweglichen Sensorplatformen eignen.

- Adaptivität. Videoanalysesysteme, welche in unbekannten Umgebungen, bzw. unter unbekannten Umgebungen eingesetzt werden, müssen in der Lage sein sich automatisch an ihre Umgebung anzupassen. Die automatische Anpassung kann dabei „offline“ durch statistische Verfahren, aber auch durch automatisches Nachlernen nach Inbetriebnahme erfolgen.

- Skalierbarkeit. Robuste Verfahren zur Szenenanalyse sind zur Zeit auf die Detektion weniger spezialisierter Objekte oder Ereignisse beschränkt. Durch die Zunehmende Vernetzung, sowie stetig steigende Anforderung an die Diskriminationsleistung von Videoanalysesystemen gewinnt insbesondere das Problem der Skalierbarkeit solcher Verfahren zunehmend an Bedeutung.

Fraunhofer-Institut für Optronik, Systemtechnik und Bildauswertung IOSB

Fraunhofer-Institut für Optronik, Systemtechnik und Bildauswertung IOSB