Aufgabe:

Ziel des Projekts ist die Darstellung und Nutzung verschiedenster Kamerasensorik in Kombination mit einer Virtual Reality Brille. Hierbei sollen sowohl Augmented Reality Verfahren als auch die Interaktionsmöglichkeiten der Virtual Reality Brille miteinbezogen werden.

Links: Die MODISSA Testplattform. Rechts: 360° Grad Kamera auf MODISSA Testplattform

Projektbeschreibung:

Die MODISSA Testplattform bietet verschiedenste Kamera- und Lokalisierungssysteme. Im aktuellen Stand des Projekts werden eine 360°-Kamera (Ladybug 5® von Point Grey) mit einer Gesamtauflösung von 30 Megapixel und eine Infrarot-Kamera auf einem Schwenk-Neige-Kopf für die Visualisierung herangezogen.

Als Virtual Reality Brille (VR Brille) wird zum jetzigen Stand eine Oculus Rift® verwendet. Bei der Oculus Rift® von Oculus VR handelt es sich um eine Virtual Reality Datenbrille, welche die Kopf-Orientierung des Benutzers misst und über ein eingebautes OLED Display ein Bild in die Sicht des Benutzers projiziert. Zusätzlich wurden auf der VR Brille zwei hochauflösende Kameras montiert, welche zur Generierung einer „Durchsicht“ verwendet werden.

Links: Schwenk-Neige-Kopf mit VGA und IR Kamera. Rechts: Die in der Testumgebung verwendete Virtual-Reality-Brille.

Innerhalb des Projekts wurden folgende Szenarien bereits realisiert:

Die verschiedenen Kamerabilder werden bei dem vorgestellten System an das Sichtfeld der Oculus Rift® angepasst. Als weiteres Feature wird der sichtbare Bildausschnitt an die Kopfbewegung des Benutzers angepasst. Dies geschieht beispielsweise im Falle der 360°-Kamera, indem jeweils der entsprechende Bildausschnitt gewählt wird. Im Falle der Infrarot-Kamera wird der Schwenk-Neige-Kopf entsprechend rotiert. Die Anpassung des Kamerabildes im Verhältnis zu der Kopfbewegung wird im folgenden Video demonstriert:

Video 1(Standing short)

Durch die Verwendung der MODISSA-eigenen Sensoren ist es möglich, während der Fahrt die Bewegung des Autos miteinzubeziehen. Durch die eingesetzten Verfahren ist es möglich, die Sicht des Benutzers auch während der Fahrt stabil zu halten.

Dem Benutzer wird durch einen Standard-Controller die Möglichkeit gegeben, zwischen den einzelnen Kameraansichten zu wechseln. Durch die Benutzung eines Controllers bietet sich für den Benutzer auch die Möglichkeit, das Kamerasichtfeld selbst ohne Kopfbewegung zu rotieren. Hiermit wird dem Benutzer eine komfortable Rundumsicht um das Testfahrzeug geboten.

Durch die Verwendung von zwei auf der Virtual Reality Brille angebrachten Kameras wird eine „Durchsicht“ für den Benutzer generiert. Die beiden Kamerabilder werden dem jeweiligen Benutzerauge gezeigt und ermöglichen eine fast normale Sicht. Mithilfe dieser „Durchsicht“ ist es dem Benutzer auch während der Benutzung möglich, sich in seiner näheren Umgebung umzusehen. Die Kamerabilder können außerdem durch die Einblendung von umgebungsspezifischen Zusatzinformationen erweitert werden.

Ansicht der auf der VR-Brille angebrachten Kamerahalterung und Kameras.

Systemaufbau:

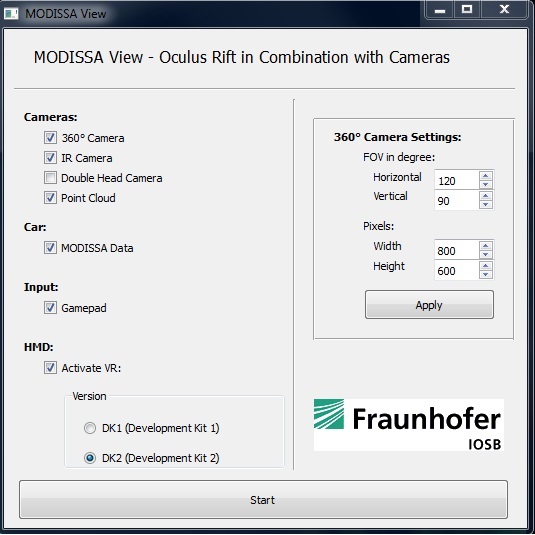

Das Visualisierungssystem besteht aus mehreren modularen Komponenten und einer Visualisierungsapplikation. Die verwendeten Komponenten (wie z.B. die Kameras) werden in einem vorgeschalteten Programm verwaltet und stehen über ein Netzwerk im Kontakt mit dem Visualisierungsprogramm. Hierdurch entsteht ein variables verteiltes System. Das vorgeschaltete Selektionsprogramm bietet dem Benutzer die Möglichkeit vor der Benutzung diverse Details einzustellen. Dies ermöglicht einen variablen Einsatz der vorhandenen Ressourcen.

Ansicht des vorgeschalteten Selektionsprogramms.

Aktuelle Projekte beinhalten unter anderem:

- Überlagerung von 360°-Bild und Infrarot-Bild für eine verbesserte visuelle Darstellung

- Ermöglichung einer „Durchsicht“ durch die Oculus Rift®-Brille mithilfe von zusätzlich angebrachten Kameras und Darstellung von Augmented Reality Objekten im Sichtfeld des Benutzers

- Virtuelle Bewegung des Benutzers innerhalb eines 3D-Umgebungsmodells

Beteiligte Mitarbeiter:

Dr.-Ing. Christoph Bodensteiner

Dipl.-Phys. Simon Lemaire

Fraunhofer-Institut für Optronik, Systemtechnik und Bildauswertung IOSB

Fraunhofer-Institut für Optronik, Systemtechnik und Bildauswertung IOSB